-

자율주행스터디_2_0121(BiFPN)자율주행스터디 2022. 1. 21. 13:01

– While previous works mainly rely on bigger backbone networks [24, 35, 34, 10] or larger input image sizes [13, 45] for higher accuracy, we observe that scaling up feature network and box/class prediction network is also critical when taking into account both accuracy and efficiency

지금까지 더 높은 정확도를 위해 인풋사이즈를 키우거나 백본 네트워크를 크게 하였지만

우리는 이러한 것이 정확도와 효율성을 동시에 생각했을 때 별로라는 생각이 들었다.

서로다른 해상도에서 피쳐들을 강조하는데에 multi scale feature funsion 이 쓰인다

P in i represents a feature level with resolution of 1/2^i of the input images.

a,c 보다 더 높은 정확도 를 b 가 가짐 그러나 더 많은 파라미터수와 연산 필요함

b 모델 효율을 위해

1. 오직 하나의 인풋엣지만 가지는 노드들을 제거 (구글번역: 우리의 직관은 간단합니다. 노드에 기능 융합이 없는 입력 에지가 하나만 있으면 다른 기능을 융합하는 것을 목표로 하는 기능 네트워크에 덜 기여 하게 됩니다. 이는 단순화된 양방향 네트워크로 이어집니다.)

2. 인풋노드와 아웃풋노드가 같은 레벨일 때 추가적인 엣지를 추가해줌

더많은 피쳐를 cost를 더하지않고도 추가해줄수 있음

3. 이것을 BiFPN 이라고 함 . top down + bottom down

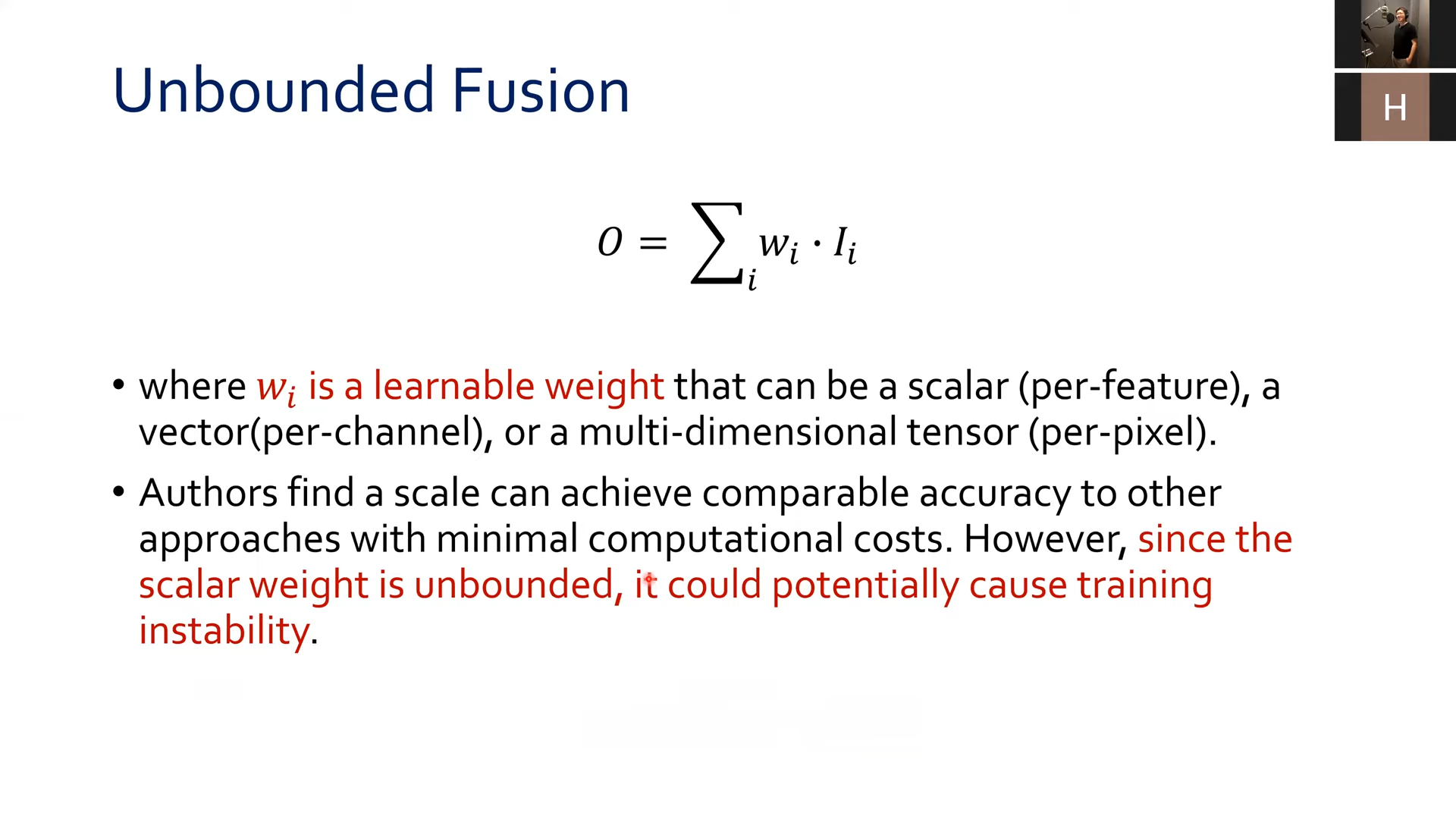

weight 이 unbound 라 값이 튀면 훈련 불안정성 생길수 있음

w_i 에 대해 렐루를 거친 얘들이 w_i>- 0 이 됨

softmax 연산이 없어 더 효율적이다

30프로 더 빠르다

두개방향 크로스스케일 연결과, 빠른 정규화를 이용함으로서 더 좋아짐

입실론은 numerical 불안정성을 해결하기위해 약간의 상수

알파,베타,감마 의 파이 승이 각각 depth, width, resol 이 된다

상수 파이를 다 키워본다

depth = layers = D

level 7 = 1/2^7 이므로 pi *128 해준다

ㅁ 몇번 반복하는지가 layers

몇번 이어 붙일 지 ...?

depth 가장 흔하게 할 수 있음

--> 적당히 와이드하고 적당히 딥하고 적당히 High resl 을 가진게 --> compound scaling

알파,베타,감마 ^ 파이 만큼 키우자

채널2배 --> 연산량(flops) 4배가 된다.

pi 를 1로 설정해 두고, 알파, 베타, 감마의 최적값을 찾고 --> 파이를 점점 늘려서 network scaling 하였다.

'자율주행스터디' 카테고리의 다른 글

PR-366: A ConvNet for the 2020s (0) 2022.01.24 PR-304: Pretrained Transformers As Universal Computation Engines (0) 2022.01.21 PR-243: Designing Network Design Spaces (0) 2022.01.21 PyTorch "ShortFormer" - RoBERTa w/Chunks(kaggle study__2) (0) 2022.01.21 자율주행 스터디_yolo_0117~ (0) 2022.01.17