-

테슬라 AI 데이 [2]_20221001정리_HW,SW 기술카테고리 없음 2022. 10. 1. 14:19

HOW IT RUNS ON TRIP : 언어모델에서 많이 차용

더보기아마 트위터 인수하면서 기술들도 많이 전수가 된 듯...

self supervised learning 기법도 언어모델에 많이 논문들 쏟아지고 있음.

sparse computation on a dense dot production engine

argmax 한 데이터와 matmul 할 데이터 : embedding table(in SRAM)로 임베딩 된값 --> 값

--> Tile --> Fuse --> Token Cache(언어모델에서 차용된 개념... 여러 칼럼값들이 들어가 있음)sparse matrix를 연산을 하기 위해서는 기존 matrix를 임베딩 차원으로 임베딩 해야

block tri diagonal 같이 효율적 계산 가능....

sparsity는 모델에서 중요한 요소.

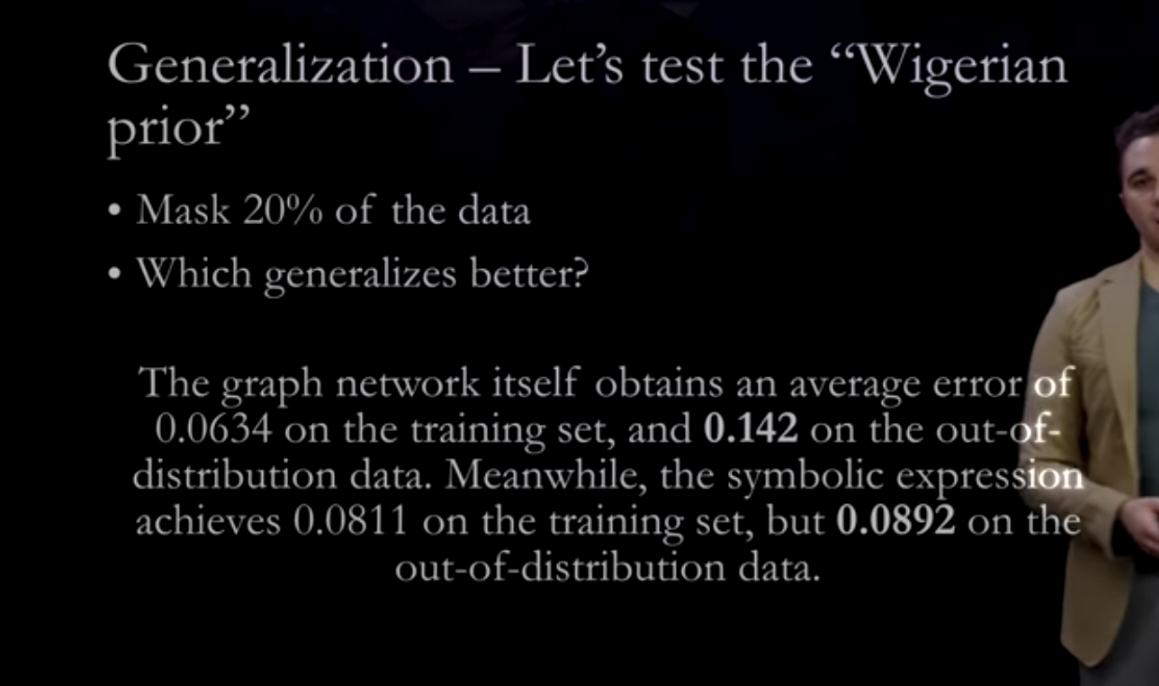

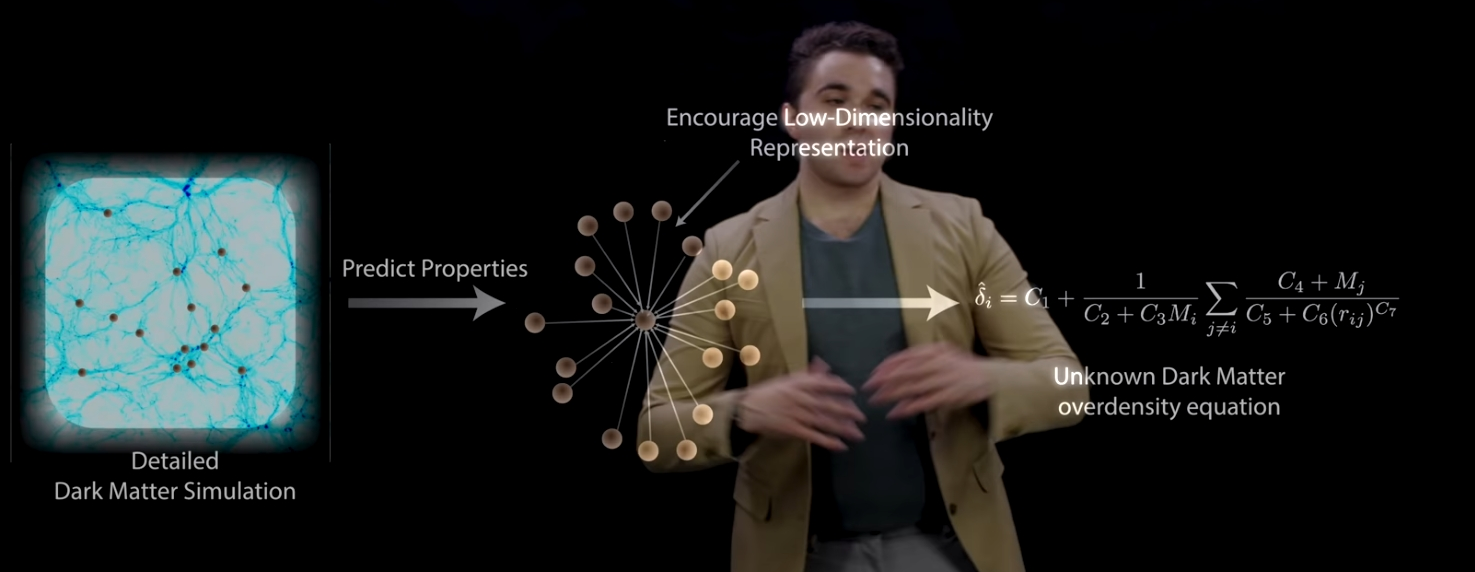

희소성 있는 차원으로 압축(embedding)하여 regression 하도록 함. 주로 sparsity는 L1 loss를 사용한다. 해밀토니안 그래프 네트워크 --> international hamiltonian 복구 가능. 분포외 데이터를 학습하는데에 좋음.dot product 은 latency 고려하여 densly 하게 만든 듯...

SOTA 언어모델 기술 사용했다 함. node, edges(도형의 선 의미) 가 landgraph에 표시

node, edge

start token 만 attribute 로 필요

first lane point: green point

두번째 Lane point : yellow ... encode its precise geometry which we do by regressing a coefficients

auto regressive, iterative on multiple attention sparse point gen directly at every step. -sparse point prediction and spare computation on a dense dot product engine LANGUAGES OF LANES

aggregate tensors to a token

--> continuous token type 으로... (language of lanes) 레인이 이 벡터 의미하는 것일 듯... token 이 어떻게 이어질 지 고민... token 이 레인의 일부분 인가??? --> 향후 댓글로 남겨주세요

GOALS : producing sparse points directly

fleet이라고하는 데이터 얻는 차량에서 오는 human demonstration(인간 실제행동)

offline solver(테슬라 서버 컴들) 이용하여 pysics based numerical optimization 보다 더 빠르게 action 수행.

좌회전 끼어들기 등 고난도 작업 수행 스코어링은 여러방법 이용. data driven approach 로 scoring

but ground it in reality with physics-based checks(constraints 준 듯.... 이 부분 loss나 알고리즘 찾아볼것)

영어는 but다음이 중요하기 때문.

8bit rgb 라고 생각하겠지만 ,

12bit raw image 는 16배 더 나은 dynamic range 를 가진다.

planning or control 를 위해서는 그 박스(fixed size box gray)가 충분치않은(not precise) 정보일수있으므로 ,

higher resolution을 만드는데 이용되는 것은 voxel 별로 feature map를 만드는 것이다.

그리고 이 피쳐맵은 MLP에 입력된다. (feed into)

OPTIMIZIND VIDEO MODEL TRAINING

데이터 movement 가 칩 내부에서 이루어져야 에너지 효율이 좋아짐.(DRAM 에서 끌고오는게 레이턴시 많이 듦)nm 단위 발표안해서 dojo 컴퓨터는 국내 S 사(대기업) 파운드리에서 제작을 계속 할 듯... (추정..)

row 단위로 저장 (DRAM, SRAM 하드웨어 인터페이스 구조상 row 단위로 버퍼에 데이터를 옮겨야 메모리 read와 write 가능)

, 텐서를 transposition 하여 저장(20%정도 효율적)

영상압축기술(11% 파일사이즈 더 효율적(작음)...어차피 aggregate 할거니 Minimum 사이즈 Op, memory format을 가짐)read overlap i frame k frame 으로 배치 지정하여 shared memory 에 저장 (package 기법 사용 ex)pipelining)

그것을 GPU double buffer memory 에 이동 : 이때 hardware decoder 사용batch size는 available GPU memory 에 제한됨

SRAM 의 cache 메모리에 저장해두면 그라디언트 전파때 꺼내 쓸 수 있어서 효과적(large batch size 불필요)

representation 의 Pre-computing and store them into a cache

자세한 내용은 Scaling Deep Contrastive Learning Batch Size Under Memory Limited Setup 논문 참고.

이 내용에 대해서 자세하게 설명을 안하긴 함...SoC 관련 추가적인 정보들이 많아야 이해 가능.

밑으로 내려갈수록 가격이 비싸기 때문에 병목을 피하기 위해서 데이터 크기를 어느정도 맞춰줘야 함.

TRIP0, TRIP1 : 2개가 하나의 SoC 에 (occupancy network, moving objects network, path planning network)

TRIP2, TRIP3 : 2개가 하나의 SoC 에 (traffic network, lanes network)

GOALS: compute all operations to natively run on TRIP engine

gpu는 DOJO 로 대체 예정

캐쉬메모리가 많이 나오는데, SRAM 으로 구현.

https://www.matthewtancik.com/nerf

NeRF: Neural Radiance Fields

A method for synthesizing novel views of complex scenes by optimizing an underlying continuous volumetric scene function using a sparse set of input views.

www.matthewtancik.com

3d reconstruction 기법

랜드마크 등을 두 개 사진으로 3d 물체를 만들어냄(3차원으로...)

여러 논문 쏟아지고 있음

(occlusion등 파악하기위해 하는듯)

+ online learning 을 위해서는 메모리의 write op가 빨라야 함.

추가자료

sparsity, self supervised가 비슷한 느낌.

unknown 을 찾기위해 임베딩 시킴.

sparsity 로 푸는 regression

unknown dynamics 를 찾음