-

transformer 논문 리뷰카테고리 없음 2022. 2. 9. 10:46

초기모델 수렴 속도 높 >> 글로벌 미니마 찾는게 더 빨라짐

레이어는 서로 다른 파라미터를 가짐

셀프 어텐션(첫번째 어텐션) 은 문장에서 각각의단어들이 서로에게 어떤 의미인가(높은 연관성) 하는 것

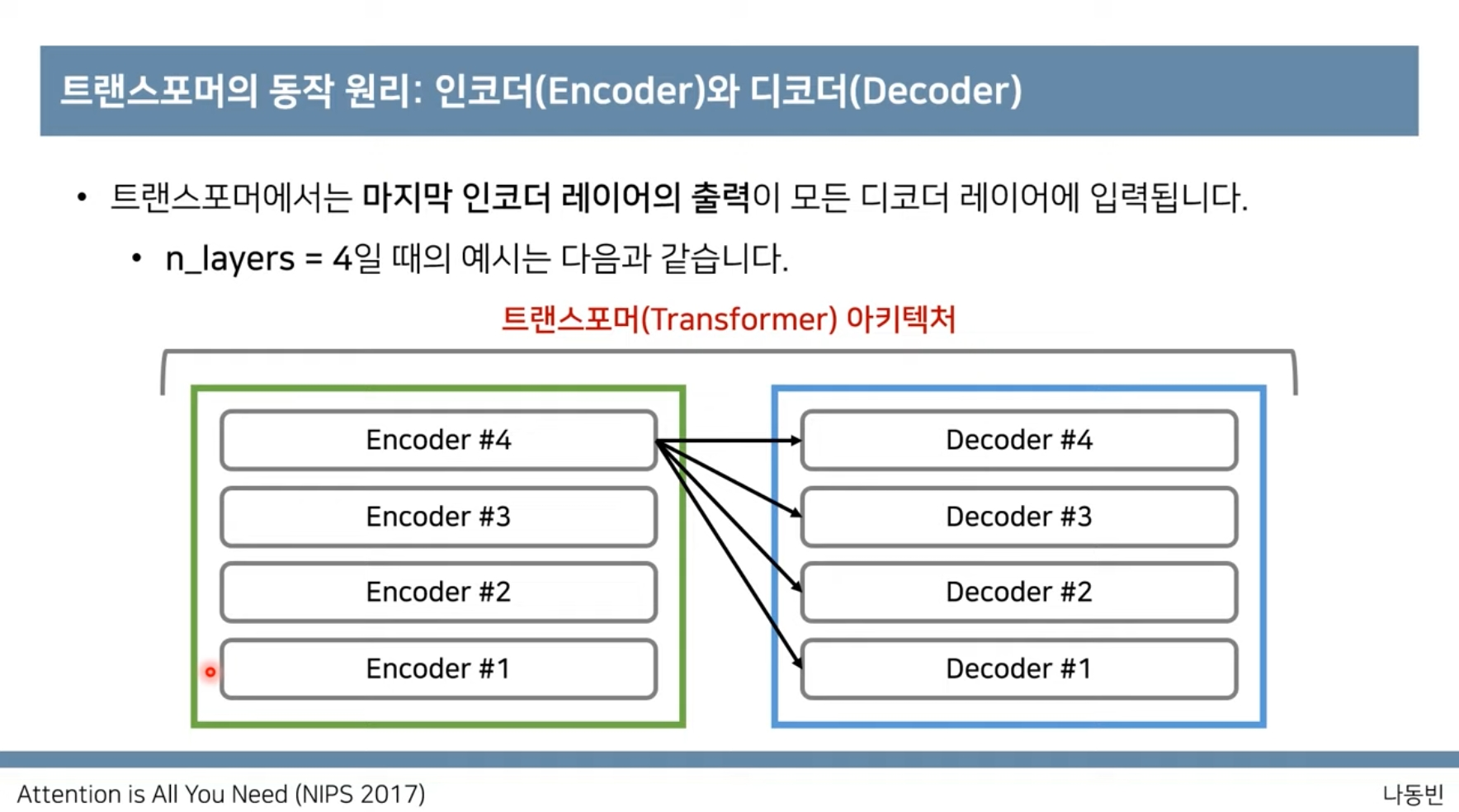

두번째 어텐션에서 인코더 의 출력을 입력으로 받아 연관성 파악

쿼리는 무언가를 물어보는 주체입니다.(단어)

각각의 단어들 이 키이다(물어보는 대상,단어)

각각의단어들이 다른단어와 어떤 연관성이 있는가???

결과값 attention value ( 가중치가 적용된)

입력문장이 들어왔을때 h개의 서로다른 attention concept -->다양한 학습 지원

벨류,키,쿼리쌍을 만들게된다

concat 해줌으로 출력디멘션이 입력과같게해준다

디코더 파트 쿼리

인코터 파트 키 벨류

키디멘션으로 노말라이션 한다